La inteligencia artificial o IA sigue avanzando y encontrándose con problemas de memoria. Uno de ellos ha sido señalado por los expertos quienes consideran que los ordenadores y dispositivos móviles tienen una capacidad limitada de memoria frente a los grandes centros, lo que se traduce en modelos de IA inferiores. Pero Microsoftha presentado un nuevo modelo que utiliza tan solo 0.4 GB de memoria, pero iguala en rendimiento a los más grandes según Timothy Green en The Motley Fool.

Además, al ejecutarse en una sola CPU, el modelo puede producir resultados a una velocidad comparable a la lectura humana, lo suficientemente rápida como para ser útil.

Incluso pueden beneficiar a firmas como Advanced Micro D e Intel.

Cambiando las reglas del juego

NVIDIA domina el mercado de aceleradores de IA, y prácticamente no hay posibilidad de que AMD o Intel puedan alcanzarlo. Siguiendo el mismo juego que Nvidia, AMD e Intel están destinados a quedarse muy por detrás del líder del mercado.

Sin embargo, los avances de DeepSeek y Microsoft plantean la posibilidad de que la inferencia de IA, el acto de ejecutar un modelo de IA entrenado para producir resultados, pueda eventualmente ejecutarse en CPU en centros de datos y dispositivos sin sacrificar la calidad. El costo continuo de ejecutar modelos de IA se reduce drásticamente si se eliminan las costosas GPU de Nvidia, y la IA en el dispositivo se vuelve mucho más atractiva para los usuarios si se pueden integrar modelos más potentes en la memoria de un PC o un smartphone.

Tanto Intel como AMD venden CPU para servidores y ordenadores que incorporan aceleradores de IA integrados. Algunas CPU para servidores EPYC de AMD destacan en ciertas tareas de inferencia de IA, y las CPU para servidores Granite Rapids de Intel pueden ejecutar modelos de 70 mil millones de parámetros. En los ordenadores, tanto AMD como Intel ahora incluyen procesadores dedicados de IA en sus CPU.

Nvidia parece imparable, y es muy posible que lo sea si asumimos que el mercado de infraestructura de IA sigue centrado en GPU ultrapotentes para centros de datos. Sin embargo, la empresa se encuentra en una situación vulnerable si los potentes modelos de IA ya no requieren sus GPU más potentes para funcionar. Si empieza a tener más sentido financiero construir un centro de datos de IA lleno de CPU en lugar de GPU, eso es lo que empezará a ocurrir. El nuevo modelo de IA de Microsoft es un paso en esa dirección.

La inversión podría empezar a desplazarse de las GPU a las CPU en el centro de datos, lo que sería una gran noticia para AMD e Intel. En el mercado de ordenadores, funciones de IA más potentes y útiles podrían impulsar la demanda de ordenadores y sacar al mercado de su estancamiento pospandémico. Un hardware más potente forma parte de la ecuación, pero también lo son los modelos de IA potentes capaces de adaptarse a memorias más pequeñas, como la última innovación de Microsoft.

Nvidia no puede perder en IA a menos que las reglas del juego cambien. Con Microsoft y otros trabajando para reducir el coste computacional y de memoria de la ejecución de potentes modelos de IA, parece que las reglas del juego están cambiando en este momento. Intel y AMD, que siempre han estado por detrás de Nvidia en el mercado de aceleradores de IA, podrían ser los grandes ganadores a medida que la inferencia de IA se traslada a la CPU.

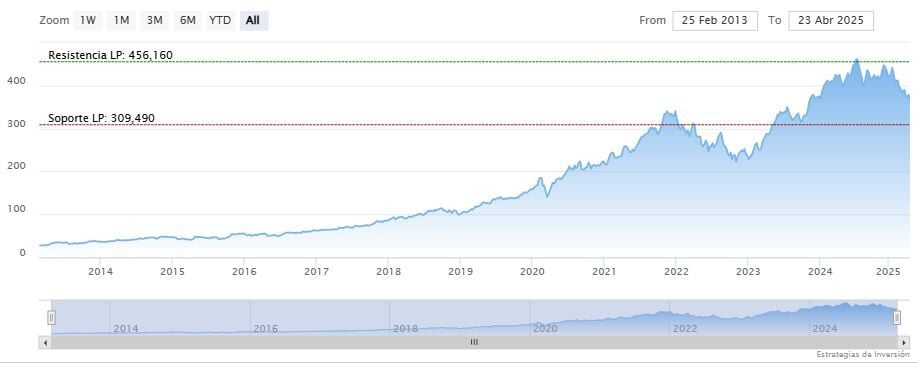

En Microsoft las medias móviles de 70 y 200 periodos se mantienen encima del precio, RSI al alza en los 52 puntos y las líneas del MACD debajo del nivel de cero.

La resistencia a mediano plazo se encuentra en los 448.38 dólares. Mientras, los indicadores de Ei se muestran mixtos.